بقلم عفاف الشلبي

يمكننا القول حاليًّا بأن تقنية ترجمة الكلام إلى كلام Speech-to-Speech translation (S2ST) قد وصلت إلى طريق النجاح باستعمال التعلم العميق.

عندما نتحدث عن الترجمة الآلية يجب أن نفصل بين الترجمة الآلية من نص إلى نص وبين الترجمة الآلية من كلام إلى كلام. وقد حظيت الترجمة الآلية من نص إلى نص بالعديد من التطورات التي أوصلتها إلى النجاح، إلا أن الترجمة الآلية من كلام إلى كلام مازالت في قيد التطوير والبحث.

تعتمد نظم الترجمة الحديثة من كلام إلى كلام على التمثيل النصي للترجمة، حيث تقوم بتحويل الكلام المراد ترجمته إلى نص، ثم تحوِّل النصَّ مرة أخرى إلى كلام. إلا أن هذه الطريقة تُفقد الكلامَ العديدَ من المعلومات والخصائص التي تُعَدُّ مهمةً في الصوت؛ مثل: العاطفة واللهجة والنبرة وغيرها من الخصائص التي يمكن اختصارها بكلمة التنغيم.

أما الطرق الحديثة في الترجمة، فتحاول استعمال نماذج الشبكات العصبونية الصنعية العميقة لترجمة الكلام إلى كلام دون اللجوء إلى التمثيل النصي، وذلك بأن تكون الترجمةُ باستعمال البيانات الصوتية الأولية مباشرة من أجل الحفاظ على خصائص الصوت التي غالبًا ما نخسرها عند تحويل الكلام إلى نص مرمَّز. يساعد التطور في مجال الحوسبة العلمية والتطور الهائل في بنية الشبكات العميقة على ترسيخ هذه الفكرة وإثباتها إثباتًا علميًّا.

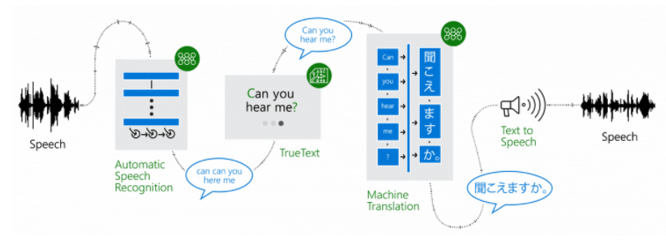

تعمل معظم النظم الحالية على مخطط عمل مكون من ثلاث مراحل، وذلك للقيام بعملية الترجمة من كلام إلى كلام اعتمادًا على تمثيل النص وهي [3]:

- المرحلة الأولى: تحويل الكلام المراد ترجمته إلى نص. يُشار إلى هذا المكون عادة بمكون تعرُّف الكلام. يحدِّد نظام تعرُّف الكلام الكلماتِ المنطوقةَ من الكلام المصْدَر ويحولها إلى نص. تُعَدُّ هذه النظم متطورةً بما فيه الكفاية لإنتاج نصٍّ جيدٍ انطلاقًا من كلام منطوق.

- المرحلة الثانية: الترجمة الفعلية، وتحدث ضمن نطاق النص. تُستعمل في هذه المرحلة نماذج الترجمة من نصٍّ إلى نصّ.

- المرحلة الثالثة: تحويل النص إلى كلام. ويُشار إلى هذا المكون بمركِّب الكلام، حيث يقوم مركب الكلام بتحويل النص المترجَم إلى كلمات منطوقة.

يوضح الشكل (1) هذه الخطوات لتحويل جملة منطوقة باللغة الإنجليزية إلى ترجمتها المنطوقة باللغة اليابانية.

الشكل (1): مراحل الترجمة الآلية من كلام إلى كلام باستعمال التمثيل النصي

يُعَدُّ أداء هذه النظم ممتازًا عندما تعمل بشكل منفصل، إلا أن استعمال مركِّب الكلام في المحادثة اليومية يجعل الصوتَ المركَّب مملًّا ويعاني من قلة التنغيم.

تشير الأبحاث الحديثة إلى أن هذه المكونات أصبحت تعتمد في المقام الأول على تقنيات التعلم العميق والتطورات الهائلة في الشبكات العميقة، وأثبتت هذه الأبحاث تحسُّن أداء هذه المكونات اعتمادًا على التعلم العميق [1].

يُعَدُّ نموذج Long Short-Term Memory (LSTM) model أحد أهم بنى الشبكات العصبونية الصنعية العميقة ذات التطبيقات والفوائد الكبيرة في تصميم نظم ذات جودة عالية.

أثبتت إحدى الدراسات إمكان استعمال النموذج السابق في الترجمة الآلية من كلام إلى كلام دون الحاجة إلى التمثيل النصيّ، وذلك من أجل الحفاظ على خصائص الصوت من الصوت المصْدَر أثناء عملية الترجمة. يجري ذلك باستعمال نموذج sequence to sequence model [2] وذلك لتمثيل كلٍّ من الصوت المصْدَر والصوت الهدف. يساعد استعمال هذا النموذج على الحفاظ على صحة الترجمة وإضافة صوت أكثر ديناميكية من حيث الحالة المزاجية والجنس والنبرة واللهجة. ولكن هذا النموذج يحتاج إلى توفر مجموعة بيانات جيدة وكبيرة بما فيه الكفاية، وهذا الأمر من أهم النقاط الحاسمة في نظم التعلم الآلي.

سنورد فيما يلي بعض النظم البرمجية القادرة على الترجمة من كلام إلى كلام:

- Google translate

يعمل نظام الترجمة من Google أساسًا على أسلوب ترجمة الكلام إلى كلام بالطريقة التقليدية؛ أي بالاعتماد على التمثيل النصي من نص إلى نص بلغة أخرى، حيث تُستعمل أداةُ تعرُّف الكلام لتحويله إلى نص، ثم ترجمة النصِّ المحوَّل، وأخيرًا يقوم نظام تركيب الكلام بتوليد الصوت المرتبط بالنص، ولكن لديه وظائف مدمجة لأخذ المدخلات من المكروفون، ثم إخراج الصوت المترجَم من مكبرات الصوت. من الجدير بالذكر أن خدمة الترجمة من Google مرشحة لتكون من أفضل المترجمات على الإطلاق من حيث الترجمات الصحيحة نظرًا إلى تنفيذها الهندسي الجيد ولوجود كميات هائلة من بيانات الإدخال من العديد من المصادر المختلفة.

- Skype translator

تحتوي خدمة (VoIP: Voice over Internet Protocol) من Skype [4] حاليًّا على إصدار تجريبي مفتوح المصدر يُمكِّنها من إجراء ترجمة شبه فورية للكلام باستعمال التعلم العميق [5]؛ فقد جرى بناء النظام - الذي يحوي ميزة الترجمة من كلام إلى كلام التي تسم Skype Translator - على نفس إعداد خدمة الترجمة من Google مع إضافة واحدة، وهي أنه يَستعمل نموذجًا صوتيًا لتحويل صوتِ المصْدَر إلى صوتٍ مترجَم مشابهٍ لصوت المصْدَر. يقوم النموذج الصوتي باستعمال نوعٍ من أصوات المترجمين، وتجريبه على صوت ذكر وصوت أنثى، ومحاولة تعيين صوت المصدر إلى أقرب نموذج صوتي للمتكلم. يساعد هذا النموذج الصوتي من الناحية النظرية على إنتاج صوتٍ مترجَمٍ أكثر ديناميكية من حيث خصائص الصوت. ومع ذلك، تعد النتيجة الحالية مرضية نوعًا ما على الرغم من أن الصوت المترجَم يبدو مثل صوت إنسان آلي يحوي أجزاءً صغيرةً من عناصر الصوت البشري.

وقد أثبتت بعض الدراسات أن خدمة الترجمة من Google تقدِّم خرجًا كلاميًّا أكثر قربًا إلى صوت البشر، على الرغم من أنها لا تستعمل نموذجًا صوتيًّا لإخراجه.

- Jibbigo

يُعَدُّ هذا التطبيق من أهم تطبيقات ترجمة تحويل الكلام إلى كلام للأجهزة المحمولة الذكية الذي يتيح للمستعمِل نُطْقَ جملةٍ ما، ثم يترجم التطبيقُ هذه الجملة ويُخرج الترجمةَ من مكبرات الصوت [6]. يدعم Jibbigo أيضًا حوارًا ثنائي الاتجاه بين المشاركين. تَعتمد هذه الطريقة اعتمادًا كاملًا على التمثيل النصي للترجمة من كلام إلى كلام.

- Moses

هو محركُ ترجمةٍ آليٌّ إحصائيٌّ يتيح تدريبَ النماذج الإحصائية بغرض ترجمة النصوص [7]. ومع أن نظام موسى Moses لا يُعَدُّ نظامًا كاملًا لنموذج الترجمة من كلام إلى كلام، فلا بد من الإشارة إليه عندما نستعرض نماذج الكلام إلى كلام. أظهرت نتائج استعمال هذا النظام جودة الترجمة الآلية التي يقدِّمها. ويُستعمل عادةً باعتباره عنصرَ مقارنةٍ للدراسات الحديثة المتعلقة بالترجمة الآلية.

الخوارزميات المستعملة في الترجمة من كلام إلى كلام

تُستعمل خوارزمية Sequence to sequence learning with neural networks مع شبكات Long short term memory network للترجمة من نص إلى نص؛ فقد استُعملت في أحد أبحاث الترجمة من نص إلى نص بين اللغة الإنجليزية والفرنسية، وهي نوع من أنواع نماذج التدريب الذي يحوِّل سلاسلَ في مجال معيَّن ذات طول محدَّد (جمل في اللغة الإنجليزية) إلى سلاسلَ في مجال معيَّن (على سبيل المثال جمل في اللغة الفرنسية) قد تختلف بطولها عن سلاسل الدخل. تتكون بنية هذا النموذج من شبكتين عميقتين من نوع LSTM، تقوم الشبكة الأولى بترميز Encoding سلسلة الدخل، وتقوم الشبكة الثانية بفك ترميز Decoding سلسلة الخرج. يساعد استعمال هاتين الشبكتين العميقتين على توليد عدد أكبر من الموسطات بتكلفة حسابية أقل، مع إمكان تدريب الشبكة على أزواج من اللغات المتعددة في وقت واحد.

يجري حاليًّا استعمال النموذج السابق للترجمة من كلام إلى كلام مع تعديل على بنية الشبكة العميقة LSTM [8]؛ فللقيام بعملية الترجمة من كلام إلى كلام باستعمال هذه البنية، تعتمد هذه الشبكات العميقة على إعدادات وحدة ترميز وفك ترميز تقليدية classic encoder-decoder، حيث تأخذ جملةَ المصْدر وترمِّزها في متجه ثابت الطول. ولإنتاج التنبؤ يُستعمل هذا المتجه الثابت الطول في فك الترميز للجملة المتوقعة. أثبتت دراسات أخرى أن متجه الطول الثابت يُعد مشكلة عند محاولة تحسين أداء نموذج الترميز وفك الترميز التقليدي. ولتجاوز هذه العقبات استعمَلت دراساتٌ حديثة نموذجَ attention model. يتيح هذا النموذج لوحدة فك الترميز القيام بعملية بحث عن الأجزاء في المدخلات المصدر الخام التي لها علاقة بالتنبؤ بالخرج، وذلك دون الحاجة إلى التعبير عن هذه المقاطع صراحة. يقوم النموذج الجديد بتوليد مجموعة من المتجهات الثابتة الطول، ثم تقوم وحدة فك الترميز بالبحث في هذه المتجهات للعثور على المواقع التي تحوي على المعلومات الأكثر صلة بها، وذلك في كلِّ خطوةِ تنبُّؤٍ في الزمن. يتيح هذا النموذج للشبكة الحفاظ على أدائها حتى عندما تصبح الجمل المترجمة أطول من الجمل التي جرى التدريب عليها في مجموعة التدريب.

تمثيل المعطيات لتدريب الشبكة العميقة:

تحتاج الشبكات العميقة إلى مصدر بيانات خام لتدريب الشبكة للقيام بالمهمة الموكولة إليها؛ حيث تحتاج هذه الشبكات للقيام بعملية الترجمة من كلام إلى كلام إلى ملفات صوتية خام. على سبيل المثال لقيام الشبكة بالترجمة من اللغة الإنجليزية إلى اللغة الفرنسية تحتاج إلى ملفات صوتية محكية باللغة الإنجليزية وملفات صوتية أخرى محكية باللغة الفرنسية. يجري عادة الحصول على هذه الملفات الصوتية من الأفلام. يَنتج عن القراءة الرقمية لهذه الأفلام سلسلة من الأعداد الصحيحة ونقاط العينات التي تمثل الصوت في جمل الفِلْم. وبما أنه يجري استعمال نموذج sequence to sequence تقوم الدراسات الحديثة على استعمال تمثيل آخر غير التمثيل الرقمي، وذلك لسببين؛ الأول أن تمثيل المدخلات السابق سيتم معالجته ككل، أي إذا أعطينا النظامَ فِلمًا كاملًا على شكل مدخل واحد، فلن نستطيع بعد ذلك إعطاء النظام جملًا أو عبارات مفردة، لأن الشبكة ستتعرَّف هذه العبارات والجمل على أنها فِلْمٌ كامل. أما السبب الثاني فيتعلق بالتمثيل الفعلي؛ إذ عادة ما يكون تردد التقطيع (أي تردد أخذ العينات) من ملف الصوت 44KHz؛ أي إننا سنحصل على 441000 عدد صحيح في كل ثانية. وحتى لو جرى تقسيم الفِلْم إلى عبارات أو جمل فسيبقى هناك تسلسلات طويلة لتعلُّمها، وغالبًا ما يكون من الصعب تعلُّم التسلسلات الأطول من التسلسلات الأقصر، لذلك تسعى الدراسات الحديثة إلى تحديد الصوت الصائت Vowel لكل مرحلة زمنية. يمتد الصوت الصائت على نافذة زمنية بطول 200ms. لذلك في كل نافذة زمنية بطول 200ms يجري عادة وصف العبارة خلالها بتحويل الإشارة الأولية إلى تحويل فورييه. يمثل تحويل فورييه الإشارة الأولية في المجال الترددي عوضًا عن المجال الزمني الذي يساعد على تحديد الترددات المهمة في كل صوت صائت.

يجري عادة تمثيل البيانات النهائية - التي هي العبارات ممثلةً بمجال التردد - بلاحقة ملف (.npy)، حيث يعد تنسيق الملف السابق الإخراج النهائي لمكتبة بايثون المعروفة باسم nump المستعملة في الحوسبة العلمية.

يجري بعد ذلك تحديد بنيان الشبكة المناسب للقيام بعملية الترجمة من كلام إلى كلام ثم تحضير مجموعة البيانات المعدة للتدريب التي تؤخذ عادة من الأفلام. فعلى سبيل المثال للقيام بعملية ترجمة الكلام إلى كلام من اللغة الإنجليزية إلى الفرنسية يجب توفر ما يلي:

- مجموعة كبيرة من العبارات، وأن تكون كل عبارة منها متاحة باللغة الإنجليزية واللغة الفرنسية.

- أن تكون العبارات متغيرة الطول.

- أن تحمل العبارات تنغيمًا طبيعيًّا كما في المحادثات اليومية.

- أن يتوفر عدد كبير من الأشخاص الذين يتحدثون بخصائص صوتية مختلفة.

اختيار بنية شبكة LSTM العميقة:

من أصعب الأمور في مسائل الشبكات العصبونية الصنعية العميقة تحديد بنية الشبكة من حيث عدد الطبقات وعدد العصبونات في كل طبقة. يجري عادة البدء بشبكة عميقة صغيرة ثم التوسع بها للحصول على نتائج أفضل، أو البدء بشبكة عميقة كبيرة ثم تقليص حجمها للوصول إلى الحجم المناسب الذي يحقق الأداء الأفضل للشبكة.

استعملَت إحدى الدراسات شبكة LSTM عميقة مكونة من طبقتين، تحتوي كل طبقة على 800 نيرون، وأعطت نتائج جيدة جدًّا.

أخيرًا، لا بد من القول إن قدرات الشبكات العصبونية العميقة أو ما يُسمَّى بالتعلم العميق ذللت كل الصعوبات في سبيل تحقيق أهداف الذكاء الصنعي.

المراجع

[1] Alan Graves, Abdel-rahman Mohamed, and Geoffrey Hinton. Speech recognition with deep recurrent neural networks. In IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), pages 6645–6649, 2013.

[2] Ilya Sutskever, Oriol Vinyals, and Quoc V. Le. Sequence to sequence learning with neural networks. The Computing Research Repository, abs/1409.3215, 2014.

[3] Li Deng, Jinyu Li, Jui-Ting Huang, Kaisheng Yao, Dong Yu, Frank Seide, Mike Seltzer, Geoffrey Zweig, Xiaodong He, Julia Williams, et al. Recent advances in deep learning for speech research at microsoft. In IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), pages 8604–8608, 2013.

[4] Skype translator. https://www.skype.com/en/features/skype-translator/. [Accessed: 2016-05-16].

[5] Skype voip software. https://www.skype.com/. [Accessed: 2016-05-16].

[6] Matthias Eck, Ian Lane, Ying Zhang, and Alex Waibel. Jibbigo: Speech-to speech translation on mobile devices. In IEEE Spoken Language Technology Workshop, 2010.

[7] Philipp Koehn, Hieu Hoang, Alexandra Birch, Chris Callison-Burch, Marcello Federico, Nicola Bertoldi, Brooke Cowan, Wade Shen, Christine Moran, Richard Zens, et al. Moses: Open source toolkit for statistical machine translation. In Proceedings of the 45th Annual Meeting of the ACL on Interactive Poster and Demonstration Sessions, pages 177–180. Association for Computational Linguistics, 2007.

[8] Bredmar Fredrik: Speech-to-speech translation using deep learning, Student essay, http://hdl.handle.net/2077/51978, 2017

تعرف العواطف من معطيات الصوت والصورة

تعرف العواطف من معطيات الصوت والصورة تتبع نظرات العين البشرية باستعمال تقنيات تعلم الآلة

تتبع نظرات العين البشرية باستعمال تقنيات تعلم الآلة تعرف الوجوه باستعمال التعلم العميق

تعرف الوجوه باستعمال التعلم العميق تركيب الكلام باستعمال التعلم العميق

تركيب الكلام باستعمال التعلم العميق