بقلم حسام عابد

مدير تطوير البرمجيات في سيريتل

1. المقدمة

ترغب جميع مواقع الوب على شبكة الإنترنت في زيادة عدد المستعملين وتحسين نوعيتهم. ويمكن تحقيق ذلك بضمان ظهور موقع الوب في نتائج محركات البحث عند استعمال الكلمات المفتاحية الملائمة. إن تحسين نتائج البحث Search Engine Optimization (SEO) هي إجرائية ترمي إلى زيادة جودة وكمية البيانات التي يرسلها ويستقبلها زوار الموقع Website Traffic، وذلك بزيادة عدد مشاهدات الموقع أو صفحات من الموقع في نتائج محركات البحث. تهدف SEO إلى تحسين النتائج غير المدفوعة والمدعوة "طبيعية" أو "عضوية organic"، ويمكن أن تستهدف أنواعًا أخرى من البحث؛ كالبحث عن الصور والفيديو والأخبار والمعلومات الأكاديمية والتخصصات المتنوعة.

إن تحسين موقع وب قد يتطلب تعديل محتوياته، وإضافة محتوى آخر، وتعديل صفحات HTML، وربما تعديل البرمجة المرافقة بهدف جعل الموقع أكثر مناسبة لبعض الكلمات المفتاحية وإزالة العوائق من طريق عمليات الفهرسة التي تجريها محركات البحث.

يهتم SEO، الذي يعتبر استراتيجية تسويق عن طريق الإنترنت، بكيفية عمل محركات البحث، وخوارزميات البحث التي تملي طريقة تصرف محركات البحث، وبما يبحث عنه الناس، والتعابير والكلمات المفتاحية المستعملة في البحث، وما هي محركات البحث التي يفضلها الجمهور. يفيد SEO في أن موقع الوب سيستقبل عددًا أكبر من الزوار في محرك البحث إذا كان ترتيب ظهور الموقع في مقدمة صفحة نتائج البحث، وأن هؤلاء الزوار قد يتحولون إلى زبائن.

2. لمحة تاريخية

بدأ مديرو المواقع ومزودو المحتوى بتحسين مواقع الوب لمحركات البحث في منتصف تسعينيات القرن الماضي؛ فقد بدأت محركات البحث الأولى بفهرسة الوب الذي ظهر آنذاك، وكان مدير النظام لا يضيف إلى محرك البحث إلا عنوان الموقع أو الصفحة URL فقط، ليقوم بعدها "العنكبوت Spider" بالزحف إلى تلك الصفحة أو الموقع لاستخراج روابط Links الصفحات الأخرى ومعلومات تلك الصفحة، ثم فهرستها Indexing. تشمل هذه الإجرائية عنكبوت محرك البحث الذي يجلب الصفحة، ويخزنها في مخدم محرك البحث الخاص. يقوم بعد ذلك برنامج آخر يدعى المفهرس Indexer باستخراج معلومات الصفحة؛ مثل: كلماتها، وأماكن وجود هذه الكلمات وأوزانها، إضافة إلى كل الروابط التي تحويها الصفحة. وتوضع هذه الروابط ضمن مُجَدْوِل Scheduler للزحف إليها Crawling لاحقًا ومعالجتها.

لقد أدرك أصحاب مواقع الوب قيمة نتائج البحث في محركات البحث وأهمية ترتيب الموقع ضمنها Ranking، فأحدث ذلك فرصًا لممارسي تحسين محركات البحث من أصحاب القبعات البيضاء والسوداء White hat and black hat.

اعتمدت الإصدارات الأولى من خوارزميات البحث على المعلومات التي يزودها مديرو المواقع مثل لصاقة الكلمات المفتاحية الوصفية Keyword Meta Tag، أو على ملفات الفهرسة في محركات مثل ALIWEB. توفر اللصاقات الوصفية دليلًا على محتوى كل صفحة. وقد تبين أن استعمال اللصاقات الوصفية لفهرسة الصفحات غير موثوق، لأن اختيار مدير الموقع للكلمات المفتاحية قد يكون غير معبِّر عن محتوى الموقع الحقيقي. فالمعلومات غير الدقيقة وغير الكاملة وغير المترابطة في اللصاقات الوصفية قد يجعل الصفحات تظهر في مواقع غير مناسبة في نتائج محركات البحث. كذلك استعمل مزودو محتوى الوب بعض الخصائص attributes ضمن الرماز المصدري HTML للصفحات في محاولة لتحسين ترتيب الظهور في محركات البحث.

وفي عام 1997 أدرك مصممو محركات البحث أن مديري المواقع يجهدون في تحسين مراتبهم في محركات البحث، وأن بعض المديرين كانوا يتلاعبون بترتيب نتائجهم عن طريق إقحام الكثير من الكلمات المفتاحية غير المناسبة في صفحات الوب. ولذلك لجأت محركات البحث الأولى مثل ألتافيستا Altavista وإنفوسيك Infoseek إلى تعديل خوارزمياتها بحيث تمنع التلاعب بالترتيب.

وبسبب الاعتماد الكلي على كثافة الكلمات المفتاحية التي يتحكم بها مدير الموقع حصريًّا، عانت محركات البحث الأولى من إساءة الاستعمال والتلاعب بالترتيب. وكان على محركات البحث، كي توفر أفضل النتائج لمستعمليها، أن تتواءم بحيث تضمن ظهور نتائج بحث أكثر دقة وذات صلة بالموضوع، بدلًا من إظهار صفحات غير مناسبة محشوة بكلمات مفتاحية عديدة. وهذا يعني الانتقال من الاعتماد على كثافة الكلمات المفتاحية إلى إجرائية شمولية لتثقيل الصفحات دلاليًّا Semantic scoring. ولما كان نجاح وشعبية محرك البحث يعتمدان على قدرته على إعطاء نتائج بحث ذات صلة بعملية البحث، فإن الجودة المنخفضة أو النتائج غير المناسبة قد تحمل الباحث إلى الإعراض عن هذا المحرك والالتفات إلى محركات بحث أخرى.

اضطرت محركات البحث إلى تطوير خوارزميات ترتيب أكثر تعقيدًا آخذةً بالحسبان معاملات إضافية يصعب على مديري المواقع التلاعب بها.

قد تؤدي التقنيات العدائية المفرطة التي تسِّخرها بعض الشركات لتعزيز وجود مواقع عملائها على محركات البحث إلى منع ظهور هذه المواقع في نتائج البحث؛ فقد أشارت صحيفة وول ستريت جورنال في عام 2005 إلى أن شركة ترافيك باور Traffic Power سخَّرت تقنيات ذات مخاطرة عالية من نمط القبعات السوداء Black hat ولم تكشف هذه المخاطر لزبائنها. وأشارت مجلة وايرد Wired إلى أن الشركة نفسها قاضت آرون وول Aaron Wall المدوِّن والخبير في مجال SEO لكتابته عن المنع. وأكَّد مات كتس Matt Cutts المهندس الذي يعمل في غوغل أن غوغل منعت فعلًا ظهور ترافيك باور وبعض زبائنها من الظهور في نتائج البحث.

توفر محركات البحث الرئيسية معلومات وإرشادات للمساعدة على تحسين مواقع الوب. من ذلك مثلًا أن لدى غوغل برنامج سايتمابس Sitemaps لمساعدة مديري المواقع على معرفة الصعوبات التي يواجهها غوغل لفهرسة مواقعهم، وتوفير معلومات عن حركة سير البيانات من غوغل إلى موقع الوب. ويوفر محرك البحث بينغ Bing أدوات Webmaster Tools تتيح لمدير الموقع تحميل خريطة الموقع، فيستطيع بذلك تحديد معدل فهرسة الموقع وتحديد حالة فهرسة الصفحات.

وفي عام 2015 أُعلن أن غوغل كانت تطور وتروج للبحث باستعمال الجوال، باعتباره ميزة رئيسية ضمن منتجاته الجديدة، مما حدا بالعديد من العلامات التجارية لتغيير منهج استراتيجيات التسويق عن طريق الإنترنت.

3. العلاقة مع غوغل

في عام 1998 طور الطالبان في مرحلة التخرج لاري بيج Lary Page وسيرجي برين Sergey Brin من جامعة ستانفورد محرك البحث "باكرب Backrub" الذي اعتمد على خوارزمية رياضية لتصنيف مدى أهمية صفحة وب ما. يعتمد رقم الأهمية PageRank الذي تحسبه الخوارزمية على جودة وقوة الروابط في الصفحات الأخرى التي تشير إلى هذه الصفحة. يقدر رقم الأهمية مدى احتمال الوصول إلى الصفحة من متصفح عشوائي للوب متتبعًا الروابط من صفحة إلى أخرى. وهذا يعني في الواقع أن بعض الروابط أقوى من بعضها الآخر، إذ إن الصفحة ذات رقم الأهمية الأعلى يزداد احتمال الوصول إليها من متصفح وب عشوائي.

أسس لاري بيج وسيرجي برين غوغل في عام 1998. وجذب غوغل متتبعين مخلصين بين مستعملي الإنترنت، وكان أكثر ما أثار الإعجاب هو بساطة التصميم. فقد أخذ غوغل بالحسبان معاملات من خارج الصفحة (مثل: رقم أهمية الصفحة، وتحليل الروابط) إضافةً إلى معاملات من ضمن الصفحة (مثل: تواتر الكلمات المفتاحية واللصاقات الوصفية Meta Tags، والروابط، وبنية الموقع) وذلك بهدف تجنب التلاعب بترتيب الصفحة الذي يمكن أن يحصل في حال اعتماد معاملات من ضمن الصفحة فقط. وعلى الرغم من صعوبة التلاعب برقم أهمية الصفحة، فقد طور مديرو المواقع أدوات لبناء الروابط للتأثير على محرك البحث إنكتومي Inktomi، وتبيَّن أنه يمكن استعمال هذه الأدوات للتلاعب برقم أهمية الصفحة PageRank بطريقة مشابهة. وكثير من المواقع تلجأ غالبًا إلى تبادل وشراء وبيع الروابط. وقد كان بعض هذه الأدوات تبني آلاف المواقع بهدف وحيد هو إنشاء روابط وهمية.

وفي عام 2004، أدخلت محركات البحث طيفًا واسعًا من المعاملات غير المعلنة في خوارزميات التصنيف بهدف التخفيف من التلاعب بالروابط. وفي حزيران من عام 2007، ذكرت مجلة نيويورك تايمز أن غوغل يصنف المواقع باستعمال أكثر من 200 معامل. علمًا بأن محركات البحث الرائدة؛ مثل: غوغل وبينغ Bing وياهو Yahoo، لا تكشف الخوارزميات التي تستعملها في تصنيف الصفحات. وقد نشر بعض المشتغلين بتحسين نتائج محركات البحث أبحاثًا وشاركوا بآرائهم في هذا الخصوص.

وفي عام 2005 بدأ غوغل بتخصيص نتائج البحث بحسب المستعمل معتمدًا على عمليات البحث السابقة للمستعمل.

وفي عام 2007، أعلنت غوغل عن حملة ضد الروابط المدفوعة Paid Links التي تغير رقم أهمية الصفحة. وفي حزيران من عام 2009 كشفت غوغل أنها اتخذت إجراءات تخفِّف من تأثير عملية "نحت رقم أهمية الصفحة PageRank Sculpting" باستعمال الواصفة "nofollow" في الروابط. وأعلن مات كتس Matt Cutts، مهندس البرمجيات المعروف في غوغل، أن روبوت غوغل لن يعالج أي رابط ضمن الواصفة "nofollow" بنفس الطريقة بهدف منع مقدمي خدمات SEO من استعمال الواصفة "nofollow" لتغيير رقم أهمية الصفحة. وقد طور مهندسو SEO تقنيات بديلة تستبدل تعليمات جافاسكريبت غير مفهومة بواصفات "nofollow"، مما يساعد على تغيير رقم أهمية الصفحة. كما اسْتُعمِلت حلول أخرى تتضمن تقنيات iframe وفلاش Flash وجافاسكريبت.

وفي كانون الأول من عام 2009، أعلنت غوغل أنها ستستعمل عمليات البحث القديمة لكافة المستعملين، وقد أعلنت في حزيران عام 2010 عن أداة فهرسة الوب الجديدة غوغل كافيين Google Cafeine، حيث أضافت غوغل كافيين تغييرًا في طريقة فهرسة الصفحات كي تظهر أسرع من قبل، فساعد ذلك على إظهار الأخبار ومنشورات المنتديات ومحتويات أخرى بعد نشرها بمدة وجيزة. يقول كاري غريمس Carrie Grimes مهندس البرمجيات الذي أعلن عن كافيين: "توفر كافيين نتائج أكثر حداثة بمقدار 50% من الفهرسة السابقة". أُدْخِلَت الأداة غوغل إنستانت Google Instant للبحث في الزمن الحقيقي في آخر عام 2010 لجعل نتائج البحث أكثر حداثةً وتناسبًا مع موضوع البحث. فقد أمضى مديرو المواقع أشهرًا بل سنوات في الماضي في محاولة تحسين نتائج البحث، ومع نمو شعبية مواقع التواصل الاجتماعي والمدونات، لجأت محركات البحث الكبرى إلى تعديل خوارزمياتها بحيث تضمن ظهور المحتوى الأحدث في الأعلى ضمن نتائج البحث.

أعلنت غوغل في شباط من عام 2011 عن التحديث باندا Panda الذي يعاقب مواقع الوب التي تحوي محتوى مكررًا عن مواقع ومصادر أخرى. فقد نسخت المواقع سابقًا محتوى من بعضها، واستفادت من ذلك في تحسين ترتيبها في محركات البحث، فاستدعى ذلك أن تطور غوغل نظامًا جديدًا يعاقب المواقع التي لا يكون محتواها فريدًا. حاول نظام غوغل بينغوين Google Penguin الذي صدر في عام 2012 أن يعاقب مواقع الوب التي استعملت أساليب ملتوية لتحسين ظهورها في محركات البحث. وعلى الرغم من أن تقديم غوغل بينغوين بدا كخوارزمية لمحاربة الإزعاج الوبي Web Spam، إلا أنه ركَّز على الروابط المزعجة Spammy Links بقياس جودة المواقع التي تصدر منها الروابط. تميَّز التحديث هامينغبيرد الذي صدر عام 2013 بتعديل في الخوارزمية يحسِّن معالجة اللغات الطبيعية والفهم الدلالي لصفحات الوب.

يقع نظام معالجة اللغات هامينغبيرد تحت المصطلح "البحث التحادثي Conversational Search" حيث يعير النظام انتباهًا لكل كلمة في سؤال البحث لمطابقة الصفحات مطابقةً أفضل مع معنى السؤال بدلًا من مطابقتها مع بضع كلمات. وبالنظر إلى التغييرات التي جرت على تحسين نتائج البحث، فإن هامينغبيرد بالنسبة لناشري وكاتبي المحتوى يهدف إلى حلِّ الإشكالات بالتخلص من المحتوى غير المناسب، وهذا يتيح لغوغل أن ينتج محتوى عالي الجودة.

4. الفهرسة

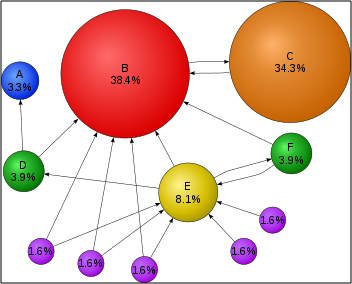

الشكل 1: مثال لروابط بين المواقع في محركات البحث

تستعمل محركات البحث خوارزميات رياضية معقدة لتخمين المواقع التي يبحث عنها الباحث. في الشكل رقم 1، تمثل كل كرة موقع وب، وتفحص برامج تدعى بالعناكب Spiders المواقع المرتبطة بمواقع أخرى، مع أسهم تشير إلى الروابط. المواقع التي تتلقى عددًا أكبر من الروابط تُعتبر أكثر أهميةً وهي ما يُفترض أن الباحث يبحث عنه. في هذا المثال، وبما أن الموقع B يتلقى الكثير من الروابط، فيأتي ترتيبه أعلى في لائحة نتائج البحث. ويكون تأثير الروابط متعديًا، فالموقع C مثلًا بالرغم من أنه يملك رابطًا وافدًا واحدًا فقط إلا أن هذا الرابط يأتي من الموقع B الذي هو أكثر شعبية بعكس الموقع E.

تستعمل محركات البحث الرائدة مثل غوغل وبينغ وياهو برامج لاستكشاف الصفحات والبحث عنها تدعى الزواحف Crawlers بهدف فهرستها للحصول على نتائج البحث. كان أكبر مصنفان Yahoo!Directory الخاص بياهو وDMOZ الخاص بشركة AOL يتطلبان عملًا يدويًّا لإدخال معلومات المواقع والصفحات ويتطلبان مراجعة بشرية للمعلومات، ولكنهما توقفا في عامي 2014 و2017 على الترتيب. يقدم غوغل خدمة Google Search Console حيث يمكن إنشاء تغذية من نوع XML لخريطة الموقع XML Sitemap Feed وإرسالها إلى غوغل مجانًا لضمان وجود كافة صفحات الموقع وخصوصًا الصفحات التي لا يمكن اكتشافها باتباع الروابط آليًّا. كذلك وفر ياهو خدمة تحميل مدفوعة تضمن الوصول إلى الموقع بنموذج الإعلان على الإنترنت Pay-Per-Click التي يدفع فيها صاحب الموقع مبلغًا عند نقر المستعملين على الرابط، وقد توقفت هذه الخدمة في عام 2009.

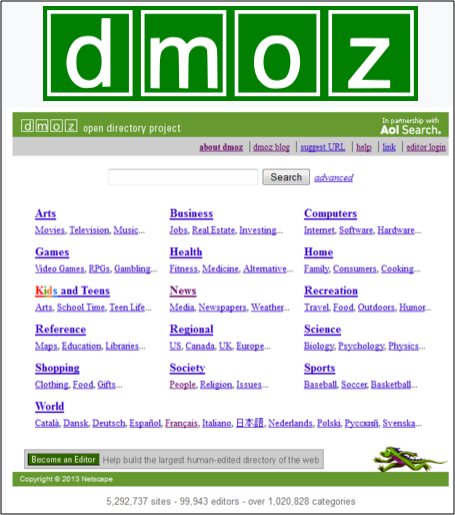

الشكل 2: الموقع dmoz.org المغلق حاليًّا

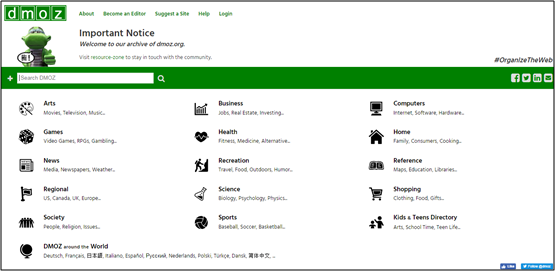

الشكل 3: الموقع dmoz-odp.org المؤرشف للموقع dmoz.org

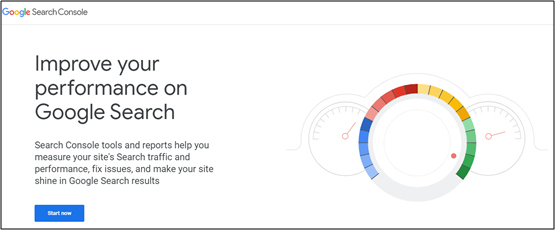

الشكل 4: الخدمة Google Search Console

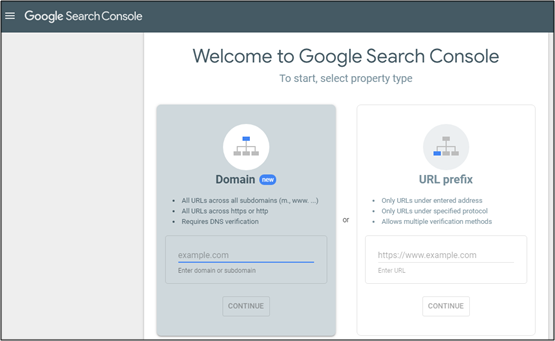

الشكل 5: الخدمة Google Search Console

تعاين زواحف محركات البحث عددًا من المعاملات المختلفة عند التنقيب في موقع ما، لأن محرك البحث لا يفهرس كل صفحة من الصفحات، كما أن بُعد الصفحة عن الدليل الجذر للموقع هو أحد معاملات تنقيب الصفحة.

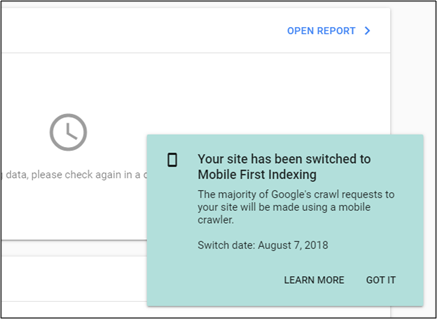

يبحث أغلب الناس اليوم على غوغل باستعمال الهواتف المحمولة، لهذا أعلنت غوغل في تشرين الثاني 2016 تغييرًا جذريًّا في طريقة تنقيب المواقع، وجعلت الفهرسة تبدأ بنسخة الهاتف المحمول من المواقع.

الشكل 6: فهرسة نسخة موقع الهاتف المحمول

5. منع الزحف

يمكن لمدير الموقع أن يعلِّم البرامج العنكبوتية ألا تنقب في بعض الملفات أو الأدلة لتجنب محتوى غير مرغوب فيه ضمن فهارس البحث، وذلك بوضع الملف المعياري robots.txt في الدليل الجذر للموقع. يمكن كذلك استثناء صفحة ما صراحةً من قاعدة بيانات محرك البحث باستعمال لصاقة وصفية Meta tag خاصة بالروبوت (هي عادة <meta name="robots" content="noindex">). عندما يزور محرك البحث موقعًا ما، فإنه يبدأ بملف "robots.txt" الموجود في المجلد الجذر، فيقرأ محتوياته ويُعْلم البرنامج الروبوت عن الصفحات التي لا يجب فهرستها. الصفحات التي لا ترغب المواقع بفهرستها هي عادةً الصفحات الخاصة بالمستعمل؛ مثل: محتويات عربات التسوق في مواقع التجارة الإلكترونية ونتائج البحث. أعلمَ غوغل مديري المواقع في آذار من عام 2007 ضرورة منع فهرسة نتائج البحث المحلية لأنها ستعتبر صفحات مزعجة وخادعة Spam.

6. تحسين الأهمية

ثمة عدة طرق لزيادة أهمية صفحة الوب في نتائج البحث. فالربط المتقاطع Cross Linking بين الصفحات ضمن نفس موقع الوب يمكن أن يحسن ظهور الموقع. وكتابة محتوى يتضمن جملًا مفتاحية يجري البحث عنها بتواتر عالٍ تكون مناسِبةً لطيفٍ كبيرٍ من طلبات البحث يسعى لتحسين الوصول إلى الموقع. إن تحديث المحتوى بهدف جعل محركات البحث تعيد الزحف إلى الموقع يمكن أن يعطي وزنًا إضافيًّا للموقع. وإن إضافة الكلمات المفتاحية المناسبة إلى اللصاقات الوصفية في صفحة الوب مثل اللصاقة <title> واللصاقة <description> سيؤدي إلى تحسين صلة الموقع بعملية البحث، ومن ثَم تحسين الوصول إلى الموقع. وإن توحيد الروابط URL Canonicalization التي تشير إلى صفحة الوب يمكن أن يضمن أن كافة النسخ من الروابط تدخل في حساب عددها، ومن ثَم في تحديد تقييم الصفحة.

7. تقنيات القبعات البيضاء والقبعات السوداء

يمكن تصنيف تقنيات تحسين نتائج البحث ضمن فئتين رئيسيتين: تقنيات تنصح بها شركات محركات البحث باعتبارها جزءًا من التصميم الجيد للموقع ندعوها "القبعات البيضاء White Hat"، وتقنيات لا توافق عليها ندعوها "القبعات السوداء Black Hat". تحاول محركات البحث تخفيف تأثير تقنيات "القبعات السوداء"، ومنها فهرسة الإغراق Spamdexing التي تهدف إلى التلاعب المقصود بفهرسة محركات البحث. تهدف "القبعات البيضاء" إلى الحصول على نتائج تستمر مدة طويلة، على حين تتوقع "القبعات السوداء" أن تُحظر مواقعها، مؤقتًا أو دائمًا، حالما يكتشف محرك البحث ألاعيبها.

تُعتبر تقنية تحسين نتائج البحث من نوع "القبعة البيضاء" إذا توافقت مع إرشادات محركات البحث، ولا تنطوي على خداع. هذا النوع ليس فقط باتباع الإرشادات بل هو ضمان أن المحتوى الذي يقوم محرك البحث بفهرسته وترتيبه لاحقًا هو نفس المحتوى الذي سيراه المستعمل. إن نصيحة "القبعات البيضاء" تتعلق غالبًا بتوليد المحتوى، وهي موجهة للمستعملين وليس لمحركات البحث، ومن ثم جعل هذا المحتوى متاحًا بسهولة لبرمجيات الفهرسة، وليس محاولة خداع برمجيات الفهرسة.

تهدف تقنية "القبعات السوداء" إلى تحسين الترتيب بطرق غير موافق عليها من محركات البحث أو تحوي نوعًا من الخداع. من تقنيات "القبعات السوداء" استعمال النصوص المخفية مثل نص لونه بلون الخلفية، أو ضمن مقطع مخفي. وثمة طريقة أخرى تهدف إلى إعادة محتوى مختلف بحسب طالب الصفحة إن كان زائرًا بشريًّا أو محرك بحث، تُدعى هذه الطريقة "التغطية Cloaking".

من التقنيات الأخرى تقنية تدعى "القبعات الرمادية Grey Hat SEO"، وهي تقع بين القبعات السوداء والبيضاء. حيث تتجنب هذه التقنية أن يجري حظر الموقع، ولكنها بالمقابل لا توفر محتوى أفضل للمستعمل. تركز هذه التقنية كليًّا على تحسين ترتيب الموقع في محركات البحث.

يمكن أن تعاقب محركات البحث المواقع التي تستعمل تقنيات القبعات السوداء، إمَّا بتخفيض ترتيبها أو بحذفها من قاعدة البيانات نهائيًّا. يمكن للعقوبة أن تُفرض آليًّا من برمجيات محرك البحث أو أن تُطبق يدويًّا بعد مراجعة الموقع. من الأمثلة على ذلك ما حدث في شباط عام 2006 عندما حذف غوغل موقع BMW الألماني وموقع Ricoh الألماني لاستعمالهما أساليب مخادعة، وقد اعتذرت الشركتان لاحقًا، وصححتا الصفحات المخالفة، وجرى إعادتهما إلى نتائج محرك البحث غوغل.

8. الخاتمة

ترتبط تقنيات تحسين نتائج البحث ارتباطًا وثيقًا بمحركات البحث التي تتفاوت حصتها في السوق. وبحسب دراسة جرت في عام 2003 فإن غوغل يستحوذ على 75% من مجمل البحث في الولايات المتحدة، وبحسب دراسة أخرى في عام 2007 فإن غوغل هو المسيطر في كافة أنحاء العالم.

التسويق باستعمال محركات البحث

التسويق باستعمال محركات البحث أهم محركات البحث

أهم محركات البحث التقنيات الحديثة لتحسين نتائج محركات البحث

التقنيات الحديثة لتحسين نتائج محركات البحث